Más allá del texto: la IA que te entiende como un humano

Imagínate esto: estás navegando por internet en un día lluvioso y encuentras una imagen de una playa paradisíaca. Te preguntas en voz alta: “¿Dónde es esto y cómo puedo ir?”. Antes de que puedas escribir la pregunta, tu asistente de inteligencia artificial ya tiene la respuesta. No solo te dice el nombre del lugar, sino que también sugiere vuelos, hoteles y hasta una playlist para mejorar tu ánimo mientras esperas el viaje.

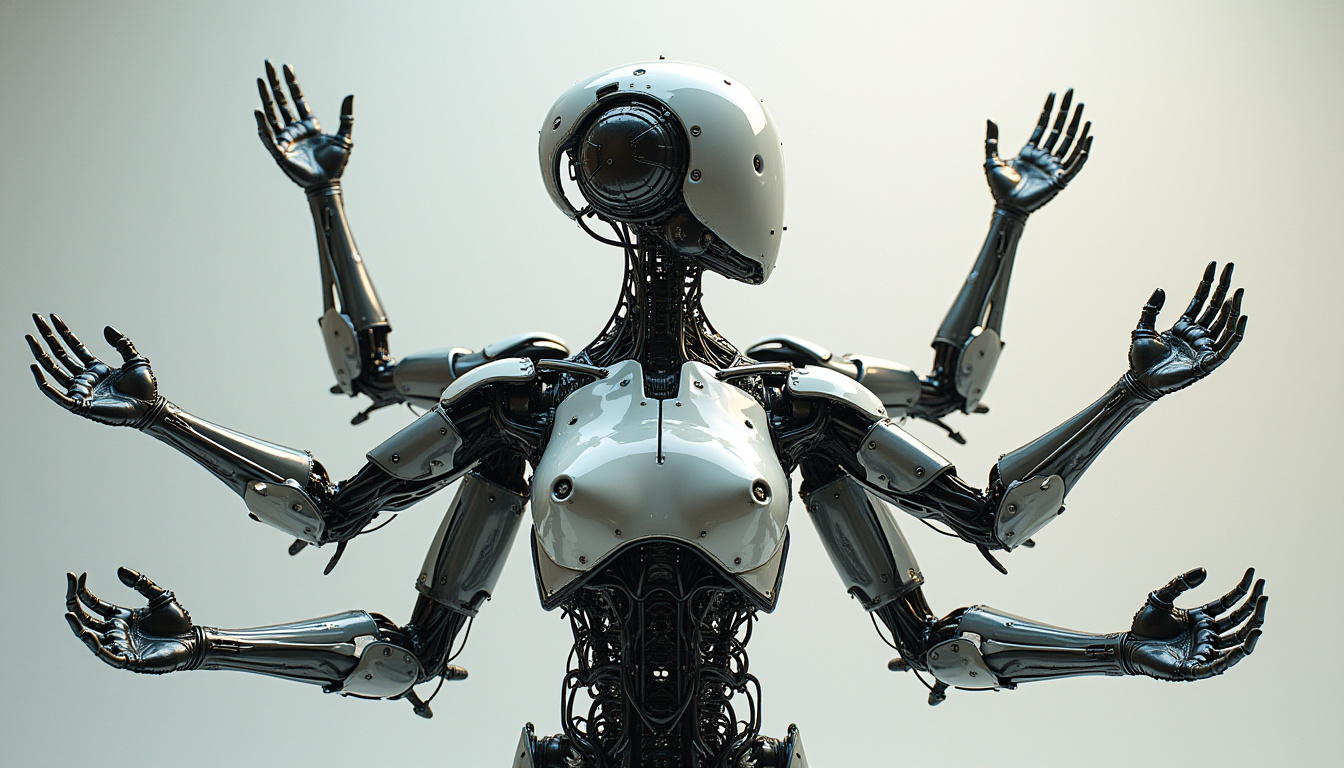

Este es el mundo que está construyendo la IA multimodal. A diferencia de los modelos tradicionales, que solo trabajan con texto, esta nueva generación de inteligencia artificial puede interpretar imágenes, sonidos y videos, integrando todo en una sola conversación. En otras palabras, no solo lee lo que escribes, sino que ve lo que tú ves y escucha lo que tú oyes.

Según Ryan Volum, líder en desarrollo de IA en Microsoft, el objetivo es claro: “Queremos que la IA perciba el mundo como lo hace un humano”. Y los avances son impresionantes.

La IA que está cambiando industrias enteras

Los modelos multimodales no son solo una novedad tecnológica, sino que ya están transformando sectores clave. En la medicina, ayudan a los doctores a detectar enfermedades difíciles de diagnosticar al analizar imágenes médicas con precisión milimétrica. En meteorología, mejoran la predicción de tormentas severas. Y en la vida cotidiana, pueden facilitar desde la planificación de un viaje hasta la elección del mejor seguro médico.

Un ejemplo claro es Copilot Vision, una herramienta de Microsoft que ayuda a los usuarios a navegar por información compleja en internet. Volum lo probó al buscar un plan de seguro médico. En lugar de leer documentos interminables, permitió que la IA analizara gráficos y textos en pantalla para resumir la información en segundos y responder a sus preguntas en tiempo real.

“Fue capaz de encontrarme en mi mundo y ayudarme mejor”, explica Volum, quien compara esta tecnología con el copiloto de un avión: “Si solo pudiera oírte, pero no ver lo que ves, sería mucho menos útil”.

Cómo funciona la IA multimodal

Detrás de esta revolución hay un avance clave: la capacidad de la IA para aprender como un humano. Los modelos multimodales se entrenan con grandes volúmenes de datos, relacionando texto, imágenes y sonidos para hacer conexiones inteligentes.

Por ejemplo, si le muestras una foto de un gato, la IA no solo reconoce la imagen, sino que también la asocia con la palabra “gato” y con su sonido característico. Esto permite que un usuario pueda preguntar en voz alta sobre lo que está viendo, y la IA responda de manera coherente.

Estos avances ya están siendo aplicados en salud, transporte y automatización, con modelos como Magma, que permite a asistentes de IA comprender su entorno, o Phi-4, una IA compacta capaz de procesar texto, voz e imágenes en dispositivos pequeños.

Los riesgos y desafíos de la IA multimodal

Sin embargo, no todo es positivo. Sarah Bird, experta en IA responsable de Microsoft, advierte sobre los riesgos de esta tecnología. “El problema no es solo lo que la IA puede hacer, sino cómo se puede usar”, explica.

Uno de los principales desafíos es la manipulación de contenido. Los deepfakes y las voces sintéticas pueden imitar a una persona de manera tan realista que resultará difícil distinguir lo auténtico de lo falso. Además, las imágenes y videos pueden tener un impacto emocional mayor que el texto, lo que podría amplificar la desinformación.

Para combatir esto, empresas como Microsoft están implementando firmas digitales en todos los contenidos generados por IA, lo que permitirá a los usuarios verificar su autenticidad. También se han reforzado los filtros de seguridad para evitar usos malintencionados.

El futuro de la IA multimodal: oportunidades infinitas

El potencial de esta tecnología es inmenso. En el campo de la medicina, se está explorando cómo la IA puede leer y entender el “lenguaje” de las proteínas, lo que podría llevar al descubrimiento de nuevos tratamientos y vacunas.

Según Jonathan Carlson, investigador de salud en Microsoft, “por primera vez podemos construir una visión holística de una célula y aprender cómo funciona a nivel molecular”.

Este es solo el comienzo. La IA multimodal no solo cambiará la forma en que interactuamos con la tecnología, sino que también nos encontrará donde estemos, anticipando nuestras necesidades y ayudándonos de manera más intuitiva.

En el futuro, no será necesario escribir comandos ni navegar por menús complejos. Bastará con señalar algo, hacer una pregunta o simplemente hablar para que la IA entienda lo que queremos y nos ayude de inmediato.

La inteligencia artificial está dejando de ser solo un asistente digital para convertirse en un compañero capaz de ver, escuchar y entender el mundo como nosotros.