¿Puede el mundo ponerse de acuerdo para limitar la IA militar? El debate que divide a la industria tecnológica

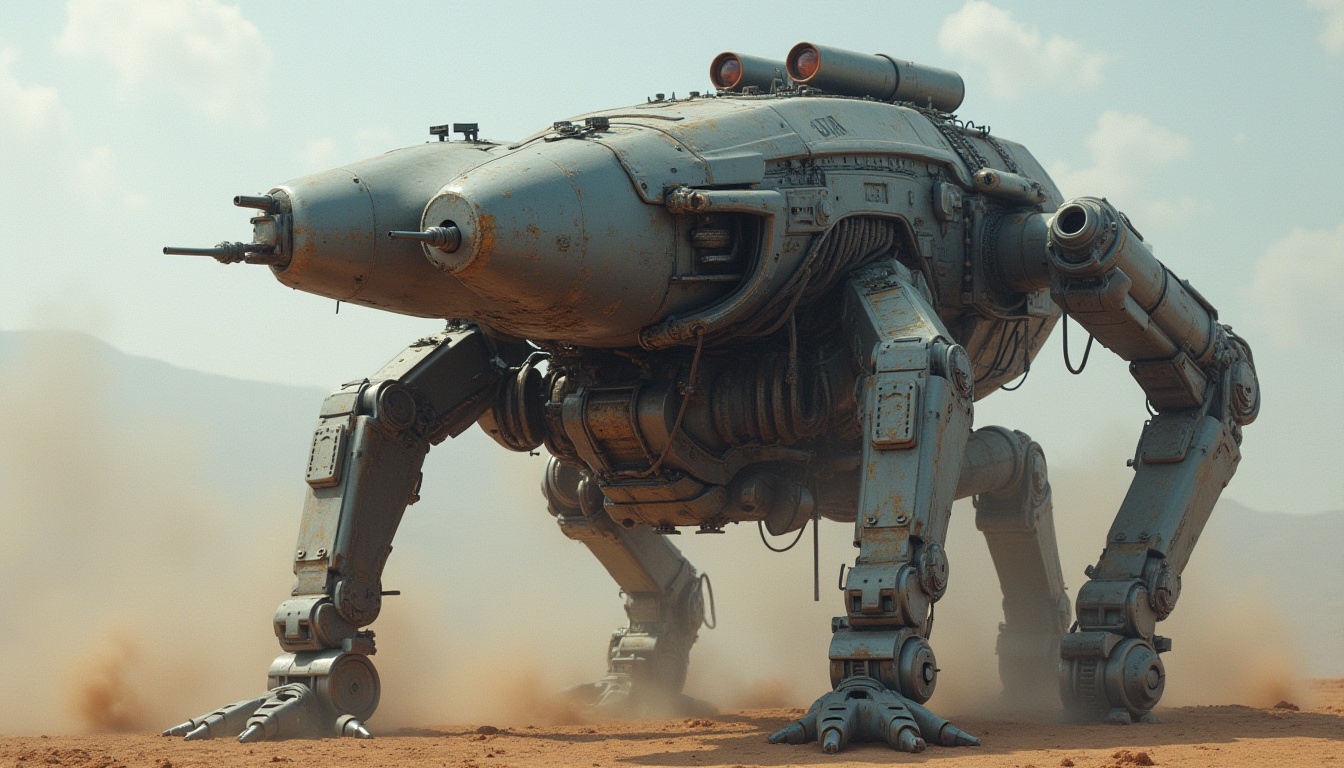

La inteligencia artificial avanza a un ritmo vertiginoso, y en el ámbito militar, la competencia entre países por desarrollar tecnologías más avanzadas no se queda atrás. Sin embargo, esta carrera no solo despierta entusiasmo, sino también miedo a perder el control.

Eric Schmidt, ex CEO de Google, y Alexandr Wang, fundador de Scale AI, han publicado un informe titulado «Estrategia de Superinteligencia», en el que advierten sobre los riesgos de convertir la IA en un arma sin restricciones. Su mensaje es claro: Estados Unidos no debería lanzar un «Proyecto Manhattan de la IA», ya que esto invitaría a una respuesta agresiva de sus adversarios.

En su lugar, proponen un «Mutuo Acuerdo de Fallos de IA», un pacto global en el que los países limiten el desarrollo de armas autónomas impulsadas por inteligencia artificial, tal como ocurrió con los tratados de no proliferación nuclear en el siglo XX.

Entre la tecnología y la guerra: el dilema de las grandes potencias

Los avances en IA no se limitan al sector comercial. Desde hace años, las grandes potencias invierten en su desarrollo con fines militares. Schmidt y Wang reconocen que la inteligencia artificial puede transformar industrias y mejorar la eficiencia en muchas áreas, pero en el ámbito bélico, los gobiernos la ven como una herramienta clave para la defensa y el dominio estratégico.

El problema es que esta carrera por la superioridad tecnológica puede derivar en un conflicto incontrolable. Según Schmidt y Wang, la presión por desarrollar IA militarizada podría llevar a ataques preventivos, ciberataques masivos y una escalada de tensiones similar a la Guerra Fría, pero en el terreno digital.

Silicon Valley y la IA militar: entre la ética y el negocio

A pesar de sus advertencias, tanto Schmidt como Wang han estado invirtiendo en proyectos de IA para la defensa. White Stork, una de las empresas de Schmidt, desarrolla tecnologías para drones autónomos, mientras que Scale AI de Wang firmó recientemente un contrato con el Departamento de Defensa de EE.UU. para crear agentes de IA para planificación y operaciones militares.

Este giro en Silicon Valley es notable. Durante años, las grandes tecnológicas evitaron colaborar con el ejército, pero hoy, con contratos multimillonarios en juego, muchas han cambiado de postura. Empresas como Anduril, de Palmer Luckey, ya han enviado drones a Ucrania capaces de atacar objetivos enemigos con IA avanzada.

Luckey defiende el uso de estas armas, argumentando que son más precisas que los misiles nucleares o las minas explosivas, que pueden causar daños indiscriminados. Pero los críticos advierten que la IA en el campo de batalla plantea riesgos incontrolables, como la posibilidad de errores en la identificación de objetivos o la deshumanización de la guerra.

El futuro de la IA en defensa: ¿regulación o caos?

El informe de Schmidt y Wang plantea una pregunta crucial: ¿es posible frenar el desarrollo de IA militar antes de que sea demasiado tarde?

El Congreso de EE.UU. ha propuesto su propio «Proyecto Manhattan de IA», al que Schmidt se opone. Si Washington avanza en esta dirección, China y Rusia podrían responder con ciberataques o sabotajes a infraestructuras clave. De hecho, hay indicios de que China ya ha infiltrado grandes compañías tecnológicas estadounidenses, y Rusia ha sido señalada por ataques a cables submarinos de fibra óptica.

En un mundo donde las rivalidades geopolíticas son cada vez más intensas, la idea de «sabotear proyectos de IA como defensa contra ellos» podría convertirse en una realidad. Pero la gran pregunta sigue en el aire: ¿habrá un punto de consenso global antes de que la inteligencia artificial se convierta en una amenaza imposible de controlar?